I detalj: gjør-det-selv geforce 9500 gt skjermkortreparasjon fra en ekte mester for nettstedet my.housecope.com.

Har du noen gang opplevd at grafikkortet ditt sluttet å virke? Gud gi selvfølgelig at dette aldri skjer, men likevel! Hva gjør du for eksempel hvis du hører at datamaskinen starter opp, men det er ikke noe bilde på skjermen (svart skjerm)?

Hva vi vanligvis gjør i slike tilfeller: erstatte et kjent fungerende skjermkort (eller bytte til integrert video) og forsikre deg om at problemene er med grafikkadapteren. Men hva skal man gjøre i dette tilfellet? Kan vi reparere skjermkort selv?

Den gode nyheten er ja: DIY-skjermkortreparasjon er fullt mulig! Det dårlige er at etter en slik reparasjon er det ingen garanti for at skjermkortet som er gjenopprettet på denne måten vil fungere i lang tid. Også selve reparasjonen kan ende uten hell hvis vi ikke følger visse regler. Men la oss snakke om alt i orden! 🙂

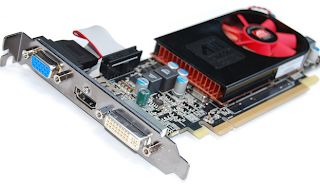

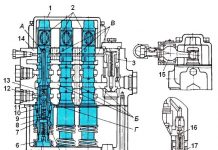

Så vi har et ikke-fungerende skjermkort fra Nvidia, GeForce 9500 GT-modellen. Her er det:

Hva er problemet? Skjermkortet fungerte i lang tid under tøffe temperaturforhold, noe som førte til overoppheting. Som et resultat av dette skjedde en ganske typisk (i slike tilfeller) ting: "dumpen" av BGA-brikken til skjermkortet.

Ikke vær redd for ordet "dump", ingenting har falt av der 🙂 Dette er bare hvordan folk kaller den elektriske kontakten til BGA-baller-arrayen med kretskortet på kortet som oppstår som et resultat av langvarig overoppheting. Vanligvis oppstår dette fenomenet som et resultat av tilstedeværelsen av en liten del av kaldlodding, som er utsatt for langvarig og sterk oppvarming.

| Video (klikk for å spille av). |

Dette er ikke å si at dette er et 100% ekteskap av produsenten: det kan være ganske mange tinnkuler i arrayet og brudd (eller oksidering) av kontakten til til og med en av dem kan føre til en fullstendig (eller delvis) tap av kortets ytelse. Så overoppheting, det være seg et skjermkort eller en sentral prosessor, er en veldig ubehagelig ting. Prøv å unngå det på alle mulige måter!

Og i denne situasjonen har vi ikke noe annet valg enn å prøve å reparere skjermkortet med egne hender, på egen hånd. Så først og fremst må vi passe på å fjerne alle plastplugger på kortet, klistremerker (klistremerker) på baksiden av kortet. Alt i området til grafikkbrikken kan smelte.

Ja Ja! Du hørte riktig: å smelte. Tross alt vil vi reparere skjermkortet ved å varme det opp, og alt "unødvendig" må fjernes, bare for hver brannmann. Selvfølgelig vil kanskje ikke noe slikt skje, men bare gjør det til en vane - det kommer godt med 🙂

Vi må også fjerne viften og kjølesystemet. Vi gjør dette med det som er mer praktisk for oss. Personlig bruker jeg denne skrutrekkeren med utskiftbare dyser:

Vi skrur ut skruene som fester viften, fjerner metalldekselet og får følgende bilde:

Som du kan se, krever kjølesystemet grundig rengjøring, og selve viften trenger forebyggende vedlikehold, siden effektiviteten har gått ned på grunn av kalk som har festet seg til bladene og støv som er klemt inn i lageret.

Det neste trinnet er å fjerne GPU-kjøleribben. Det ser ut til: hva er så vanskelig her? Men, som en filmhelt sa i en film om forskjellige onde ånder: "Det er en hake overalt!" Her ligger det i det faktum at ofte (spesielt hvis brikken ble operert i et alvorlig temperaturregime), når den er tørr, limer den termiske pastaen tett sammen krystallen og kjøleribben.

Det er kategorisk ikke anbefalt, i dette tilfellet, å bruke heroisk makt og dra denne saken over deg selv, eller, som erfaringen feilaktig tilsier, å plukke opp noe! Dette kan skade krystallen! Det er en enklere og mer elegant løsning: vi tar en vanlig husholdningshårføner og varmer sakte opp clutchområdet.

Etter en stund (5-10 sekunder) begynner vi å riste radiatoren litt fra side til side, som på bildet ovenfor. Termisk pasta, mykning under påvirkning av temperatur, vil tillate oss å gjøre dette. Ved å varme opp denne tingen litt mer, kan vi enkelt skille radiatoren vår fra krystallen:

Prøv så fullstendig og så nøye som mulig å rengjøre både "basen" av radiatoren og selve krystallen fra restene av den gamle tørkede termiske pastaen. Prøv samtidig å ikke skrape metalloverflaten til radiatoren (dette vil redusere varmeoverføringskoeffisienten). Ikke skrap, det er bedre å varme opp separat og tørke av den gamle pastaen.

Med krystallen er det også så forsiktig som mulig: hvis du ikke klarte å fjerne en del av pastaen (som min, for eksempel), så er det bedre å forlate den. Alt som er slettet - sørg for å slette! Ellers vil den termiske pastaen, under påvirkning av temperatur,, som de sier, "bake", og da vil det være veldig vanskelig å fjerne den uten å skade (chippe) selve kjernen.

Før vi begynner å reparere et skjermkort med egne hender, la oss se nærmere på grafikkbrikken.

Hvorfor fremhevet jeg noen av områdene på bildet ovenfor? Se, det større området er selve grafikkortbrikken, og det mindre området er GPU-matrisen (GPU - grafikkbehandlingsenhet). Langs omkretsen av krystallen ser vi et hvitt tetningsstoff (forbindelse), som utfører flere funksjoner: det beskytter krystallen mot støv som kommer under den og fester den til underlaget.

Hva er "trikset" her og hvorfor reparasjon av et skjermkort med egne hender kan ende uten hell, uansett hvilken innsats vi gjør? Området (arrayet) av BGA-loddekuler er ikke bare mellom selve brikken og PCB-tekstolitten, men også mellom krystallen og underlaget grafikkort!

Føler du hvor jeg skal? Den harde realiteten er at vi kan reparere skjermkortet selv (hvis vi fortsatt er heldige) bare hvis det er et brudd på kulekontaktene direkte mellom PCB og underlaget. Hvis "dumpen" skjedde under krystallen, kan vi nesten ikke gjøre noe med det. Selv en slik operasjon som reballing (fullstendig utskifting av en rekke baller ved hjelp av en sjablong) vil ikke redde i dette tilfellet, siden denne prosedyren utføres bare for "bunnen" av hele brikken, men ikke for krystallen!

Så jeg håper vi har lært det nødvendige minimum av teori? La oss gå videre! For å reparere et skjermkort hjemme trenger vi en fluss og en engangssprøyte. Jeg bruker den vanlige GFR (alcohol-canin), som kalles "GFR-flux".

Vi samler stoffet i en sprøyte (omtrent en terning). Hvis det blir stående vil det være mulig å drenere tilbake.

Merk: Du kan bruke hvilken som helst annen inaktiv (ideelt sett nøytral) fluks. For eksempel "F1" eller "F3". Den originale LTI-120 er også egnet. Selv om, med LTI, ikke alt er så enkelt: la det være en siste utvei 🙂

Vi legger forsiktig spissen av nålen til kanten av underlaget, vipper den slik at fluksen vi klemmer ut av sprøyten er under brikken. Etter å ha pumpet det, om nødvendig, vipp kortet litt slik at det sprer seg godt mellom kulene. Ideelt sett ønsker vi å oppnå en effekt hvor væsken kommer til syne litt fra alle kanter.

Råd: etter bruk, skyll sprøyten (bare ta flere ganger med vann fra springen og klem ut gjennom kanylen). Hvis dette ikke gjøres, vil kolofonium i nålen tørke ut og tette den. Det vil ta lang tid å rengjøre eller kaste.

Nå kan vi være sikre på at fluksen vil fylle sin funksjon når den varmes opp. Hvorfor flukser er nødvendig, hva de er og hvordan du bruker dem riktig, vurderte vi i en egen artikkel, så vi vil ikke gjenta oss selv.

Etter det kan vi fortsette direkte til reparasjonen av skjermkortet med egne hender! For å gjøre dette plasserer vi den på en slik måte at vi har fri tilgang til GPU ovenfra og under, og ved å bruke en loddestasjon begynner vi å varme opp underlaget rundt omkretsen.

Merk: Varm under ingen omstendigheter selve krystallen! Det kan mislykkes!

Hvordan jeg gjør det må jeg heller vise deg i videoformat, siden du ikke klarer å illustrere her med bilder alene.

La oss nå kommentere denne videoen litt.Når du varmer opp skjermkortet nedenfra (under brikken), prøv å holde hårføneren vinkelrett på planen til PCB-en, ellers klarte jeg ikke å skyte og varme den samtidig. Vær også forsiktig så du ikke blusser de små kortkomponentene på baksiden (de kan enkelt flyttes, gitt den oppvarmede loddetinn under).

I videoen over viste jeg ikke hele prosedyren, som du forstår. Det er nødvendig å varme bunnen i lang nok tid (3-5 minutter) slik at røyken fra fluksen, som du kanskje har lagt merke til, begynte å stige ganske intensivt over brettet (dette er et bevis på at brettet har varmet opp vi vil). Det første trinnet vil være "koking" og bobling av fluksen - dette er normalt.

Ikke nøl med å varme opp stedet under selve krystallen (du kan gjøre dette gjennom brettet). Det viktigste: ikke hold hårføneren på ett sted - flytt den jevnt over området (for å utelukke steder med lokal overoppheting av overflaten). Hold trakten til hårføneren i en avstand på 2-3 centimeter fra overflaten som skal behandles. Jeg personlig setter luftstrømmen til en gjennomsnittsverdi, temperaturen som loddestasjonen viser samtidig er 420-450 grader Celsius. Den andre verdien er grensen for min "Ya Xun 880D".

Temperaturspredningen her skyldes det faktum at selve sensoren er plassert direkte i håndtaket på varmluftpistolen, og lufttemperaturen ved utløpet av varmluftpistolen er allerede forskjellig (lavere). Pluss, her kan du legge til det uunngåelige varmetapet på grunn av evnen til å absorbere og spre varme av den behandlede overflaten selv, temperaturen i rommet, nærheten av hårføneren til det oppvarmede området, kraften til luftstrømmen, etc. . Det er derfor bare empirisk vil det være mulig å velge den nøyaktige verdien av driftstemperaturen (termisk profil) for en bestemt loddestasjon.

Til hvilken tilstand bør du varme opp? Her er det igjen indirekte tegn som vi kan navigere etter. Hele prosedyren tar omtrent 5-8 minutter. Tidsspredningen skyldes faktorene nevnt ovenfor. Det avhenger også av kvaliteten på flussen som brukes, typen loddemetall som BGA-arrayen er laget av på et underlag (bly eller blyfritt). I prosessen med sterk oppvarming, bør fluksen fordampe (røyke) ganske anstendig.

En viktig markør kan også være den visuelle deteksjonen av smeltingen av loddetinn på elementene som er plassert på brikken rundt formen (vanligvis en serie små SMD-kondensatorer). Når loddetinn "lyser" på dem, er det et sikkert tegn på at kulene på underlaget har nådd smeltepunktet, som er akkurat det vi trenger! For større selvtillit kan du ta en pinsett i den ledige hånden og prøve å flytte selve brikken litt: skyv den forsiktig (bokstavelig talt med en millimeter) til siden, og du vil se hvordan den "svinkler" og på grunn av overflatekreftene spenningen til de smeltede kulene nedenfra, vil smekke på plass. Etter det kan oppvarmingen trygt stoppes!

Merk: noen håndverkere, i stedet for en stasjon, bruker en vanlig bygningshårføner eller reparerer skjermkortet med egne hender, "baker" det i en husholdningsovn, etter å ha pakket det inn i folie! Ærlig talt er jeg ikke en fan av slike radikale metoder for "reparasjon", selv om (hvis gutta lykkes med alt), hvorfor ikke? 🙂

Under oppvarmingsprosedyren kan du overvåke overflatetemperaturen med et termoelement eller pyrometer (infrarødt termometer). Dette vil i fremtiden bidra til å bedre navigere i valg av riktig termoprofil.

Merk: Når du avkjøler skjermkortet (og andre elementer), ikke bruk tvungen luftstrøm - vifte, etc. La delen avkjøles naturlig, ingen grunn til å "passe" den. Vi trenger vel ikke mikrokretsen for å motta et termisk sjokk (sjokk)?

Slik reparerer du et skjermkort med egne hender! Om de var vellykkede eller ikke, har vi ennå ikke bekreftet. For å gjøre dette, må vi gjøre noen obligatoriske ting. Av vane renser jeg (der det er mulig) brettet fra flussrester. I dette tilfellet er det kolofonium som er igjen etter fordampningen av den alkoholiske komponenten. Harpiksen er nøytral (den samhandler ikke med komponentene i brettet), og i teorien er det ikke nødvendig å vaske den av, men la oss for ordens skyld gå grundig gjennom den med en børste og et rengjøringsmiddel.

Vi vasket mer eller mindre (harpiksen oppløst), lot den tørke og påfør fersk termisk pasta på krystallen ("KPT", "AlSil" eller "Zalman" - jeg respekterer):

Nå setter vi hele "konstruktøren" sammen igjen (vi fikser kjøleribben, skru på kjøleren, koble den til kontakten på brettet).

Før du installerer kortet i systemenheten, la oss gå (i tilfelle) med et elastisk bånd over pinnene på Pci Express-kontakten og det er det - kan du installere en komponent på hovedkortet for å sjekke hva vi har?

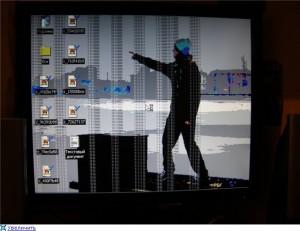

Men det viste seg, som vi kan se, alt ikke engang er dårlig. Det er et bilde på skjermen! Gjør-det-selv skjermkortreparasjon er mulig! Selvfølgelig, for å være helt sikre, må vi installere operativsystemet (det var ikke for hånden), installere skjermkortdriveren og, ideelt sett, kjøre en slags stresstest for stabilitet, som vil vise oss til slutt, vi klarte å reparere skjermkortet selv eller nei?

Merk: Det gratis og brukervennlige verktøyet "FurMark" kan fungere veldig bra for denne testen.

Ellers kan alt skje: skjermkortet ser ut til å fungere, men driveren er ikke installert eller består ikke stabilitetstesten. Som du forstår kan vi heller ikke gi noen garanti for denne typen "reparasjoner" og vi vet ikke hvor lenge enheten vil fungere? Men, som de sier, på den annen side "pumpet vi over ferdighetene" med å reparere skjermkort hjemme, og klienten fikk en midlertidig fungerende datamaskin. Vi gjorde det vi kunne, og så blir det det som skal skje!

Som alltid venter jeg på dine kommentarer, tilbakemeldinger, konstruktiv kritikk nedenfor under artikkelen 🙂

Statisk, dette er når en høyspentbue på ca. 1000 volt og over bryter gjennom (dette er ikke spesifikk informasjon

PS: Det var et tilfelle da jeg ventet på at en kropp skulle sydd, da fikset jeg på en stol og bestemte meg for å strekke på bena (det viste seg mot batteriet). og i hendene holdt han et par, koblet sammen via en ledning. Vel, jeg tok på batteriet til et sted hvor det ikke var maling - så ble jeg så knullet gjennom bein-kropp-arm at jeg fløy avgårde med en stol til den andre enden av kontoret (+ overraskelsen virket). Hvordan spre bena

Å starte videobrikken på nytt er ubrukelig - enten fungerer det eller ikke. Det er ingen tredje. Hvis gjenstandene gikk - dette er dødskampene. Du kan varme opp krystallen til videobrikken ved en temperatur som ikke er høyere enn 360 grader og ikke mer enn 5 minutter. Etter det vil den leve en stund. Videobrikken vil tåle 2-3 slike oppvarminger og da vil den dø helt.

De blir bare skadet hvis de trenger å bli levert fra en donor, eller hvis en bærbar datamaskin blir fanget etter litt vann, og i de fleste tilfeller enten varmes opp eller erstattes med en ny.

Dessverre er dette ikke telefoner. Jeg ville ha blitt millionær nå hvis opprøret hjalp. Hva er det å sykle med et slikt trinn?

Tro det eller ei, 440GTS kastet masse på batteriet, fjernet kjøleribben fra kjernen, avfyrte en piezo fra en lighter direkte på kjøleribben (vel, du forstår hva jeg mener), jeg gjentok dette 40-50 ganger, så " begavet" minnet med lignende eksperimenter, er resultatet hvordan det fungerte og fortsatte å fungere ("tilpasset" med en sidekick for en garanti).

Et slikt problem starter jeg spillet (Doom 3, Two worlds, etc.) og etter kort tid blir skjermen blank. Skjermkortet er kuttet ned og du må starte på nytt. Jeg prøvde å endre driveren, DirecX 11 (kanskje på grunn av det).

CPU-type QuadCore Intel Core 2 Quad Q9400, 2666 MHz (8 x 333)

Hovedkort Gigabyte GA-P31-S3G (3 PCI, 3 PCI-E x1, 1 PCI-E x16, 2 DDR2 DIMM, lyd, Gigabit LAN)

Intel Bearlake P31 hovedkort brikkesett

Systemminne 2048 MB (DDR2-800 DDR2 SDRAM)

DIMM1: Samsung M3 78T2863RZS-CF7 1GB DDR2-800 DDR2 SDRAM (6-6-6-18 @ 400MHz) (5-5-5-15 @ 333MHz) (4-4-4-12 @ 266MHz)

DIMM3: Samsung M3 78T2863RZS-CF7 1 GB DDR2-800 DDR2 SDRAM (6-6-6-18 @ 400MHz) (5-5-5-15 @ 333MHz)

Videoadapter NVIDIA GeForce 9500 GT (512 MB)

Skjerm Acer AL1916W [19" LCD] (6250C9B14010

Temperatur (Everest): Diode GPU-temperatur - 68 (i spill stiger den kraftig til 80-86, og kanskje målte den ikke videre), CPU-temperatur - 42, 32, 42, 40 for hver av de fire kjernene (når du spiller den stiger med et par grader).

Datamaskinen er ny (jeg kjøpte den i begynnelsen av i fjor) og det hele startet nylig, det ble ikke observert før.

Nettstedet, DIY Computer Repair, tilbyr et sett med praktisk informasjon om reparasjon, oppsett av datamaskiner og Windows med egne hender. Her kan du finne tips om hvordan du kan fikse denne eller den feilen på datamaskinen på egenhånd. Hvordan installere og konfigurere Windows OS. I tillegg publiseres det jevnlig interessante nyheter og artikler på nettstedet.

Det er her utgangene til skjermkortet er plassert. Vær oppmerksom på at sporpanelet på nesten alle utvidelseskort er tilgjengelig fra utsiden av PC-dekselet. Derfor er alle nødvendige innganger og utganger plassert på den.

En datamaskin er en digital maskin, så det digitale formatet for en datamaskin er "native", det er bedre å bruke det til å koble en skjerm til et skjermkort. Moderne skjermer har kommet langt fra de første katodestrålerørene (CRT) til flytende krystallskjermer (LCD). CRT-skjermer er analoge av natur, så for dem konverteres det digitale signalet til analogt ved hjelp av en digital-til-analog-omformer (DAC), som er plassert på skjermkortet. Med bruken av flytende krystallskjermer har behovet for en DAC forsvunnet, men denne komponenten er fortsatt tilstede ved tilkobling av analoge CRT-skjermer.

Kompositt cinch-videoutgang, også kjent som en RCA-kontakt (Radio Corporation of America).

Komponentutgangene er for store til å passe på et skjermkort, så en adapter brukes nesten alltid. Vanligvis gir adapteren komponentvideo (de tre første kontaktene) og lyd (de to siste kontaktene). Denne standarden sørger for tre separate tulipankoblinger: "Y", "Pb" og "Pr". De gir separat fargeinformasjon for HDTV (High Definition TV). Denne typen tilkoblinger finnes også på mange digitale projektorer. Selv om signalet overføres i analog form, kan kvaliteten sammenlignes med høydefinisjons VGA-grensesnittet. High-definition (HD) video kan overføres gjennom komponentgrensesnittet.

HDMI står for "High Definition Multimedia Interface". HDMI - fremtidens standard full beskrivelse av HDMI. Dette er det eneste grensesnittet som gir overføring av video- og lydinformasjon over en enkelt kabel. HDMI ble designet for TV og filmer, men databrukere vil også kunne stole på HDMI for å se HD-video.

Grafiske grensesnitt

Med sin grensesnittdel settes skjermkortet inn i hovedkortet på datamaskinen. Faktisk er dette et spor der datamaskinen og skjermkortet utveksler informasjon. Siden hovedkortet vanligvis har et spor av én type, er det viktig å kjøpe et skjermkort som passer til det. For eksempel vil ikke et PCI Express-skjermkort fungere i et AGP-spor.

PCI-grensesnittet er den moderne standarden for de fleste utvidelseskort, men skjermkort flyttet på en gang bort fra PCI-grensesnittet til AGP-standarden (og senere til PCI Express). Noen datamaskiner har ikke AGP- eller PCI Express-spor for grafikkoppgraderinger. Den eneste muligheten for dem er PCI-grensesnittet, men skjermkort for det er sjeldne, dyre, og ytelsen deres lar mye å være ønsket.

PCI-X står for "Peripheral Component Interconnect - Extended", det vil si at vi har en 64-bits buss med en båndbredde på opptil 4266 MB/s, avhengig av frekvensen. PCI-X (ikke å forveksle med PCI Express!) er den første høyhastighetsoppgraderingen til PCI Express-bussen, men den kommer også med en rekke funksjoner som er nyttige på serverplassen. PCI-X-bussen er ikke veldig vanlig i vanlige PC-er, og PCI-X-skjermkort er svært sjeldne.Du kan installere et PCI-X-kort i et vanlig PCI-spor hvis det støtter den nyeste versjonen av standarden (PCI 2.2 eller høyere), men ikke er kompatibelt med PCI Express PCI-X-standarden.

AGP - et grensesnitt med høy båndbredde spesielt utviklet for skjermkort. Den er basert på PCI-spesifikasjonen versjon 2.1. AGP-grensesnittet har gått gjennom flere versjoner, med den siste AGP 8x med 2,1 GB/s, som er åtte ganger raskere enn den originale AGP-standarden på 266 MB/s (32 bits, 66 MHz). AGP på nyere hovedkort viker for PCI Express-grensesnitt, men AGP 8x (og til og med AGP 4x) gir fortsatt nok båndbredde for moderne skjermkort. Alle AGP 8x-kort kan fungere i både AGP 4x og AGP 8x spor.

I motsetning til ISA, PCI og AGP, er PCI Express-standarden seriell, ikke parallell. Derfor har antallet kontakter gått betydelig ned. I motsetning til parallelle busser er den nødvendige båndbredden tilgjengelig for hver enhet. Mens for eksempel for PCI deles båndbredden mellom kortene som brukes.

PCI Express lar deg kombinere flere enkeltlinjer for å øke gjennomstrømningen. PCI Express x1-sporene er korte og små, men tilbyr likevel en totalhastighet på 250 MB/s i begge retninger (til og fra enheten). PCI Express x16 (16 baner) gir en gjennomstrømning på 4 GB/s i én retning, eller 8 GB/s totalt. De mindre PCI Express-sporene (x8, x4, x1) brukes ikke til grafikk. Det skal bemerkes at et spor mekanisk kan tilsvare x16-linjer, men logisk sett kan et mindre antall av dem kobles til det. Det er mange hovedkort som har to PCI Express x16-spor som kan fungere i x8-modus, som lar deg installere to skjermkort (SLI eller CrossFire).

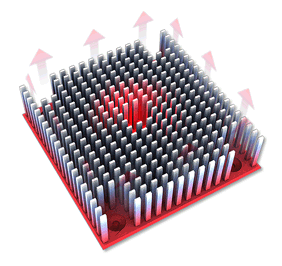

Grafikkort kan forbruke (og dermed frigjøre) like mye strøm som en 150W lyspære. Denne mengden varme som genereres fra overflaten til en enkelt silisiumbrikke kan lett brenne formen. Derfor bør varme fjernes i tide ved hjelp av stabile og kraftige kjølere. Uten kjølesystemer kan grafikkprosessoren eller minnet overopphetes, noe som vil føre til "henging" av datamaskinen, og i verste fall til og med til feil på skjermkortet.

Avkjøling kan utføres både passivt ved hjelp av varmeledende materialer og radiatorer, og aktivt hvis viften går. Men i sistnevnte tilfelle må du nøye deg med et økt støynivå.

Ordet "radiator" (kjøleribbe) forstås vanligvis som passiv kjøling. Kjøleribben senker temperaturen på brikken den er koblet til ved å spre varme og øke varmevekslingsområdet med luften. Radiatorer bruker vanligvis finner til dette formålet. De kan finnes på GPUer så vel som minnebrikker.

Her beskrev jeg problemet mitt -> klikk

Jeg bestemte meg for å kjøpe et nytt skjermkort, nemlig modellen som opprinnelig var (9700). Her fant jeg noe. Er dette normalt eller kan du anbefale et annet produkt (av samme modell)?

Kommentar: Dette innlegget er flyttet fra tråden Upgrade and Upgrade Notebook. Flyttet: jernbane

Kommentar: Dette innlegget er flyttet fra tråden Upgrade and Upgrade Notebook. Flyttet: jernbane

brsgvrn,

Kan du fortelle meg kommandoene for "NVFLASH"? For å blinke 9500M GS til 8600M GT.

Kommentar: Dette innlegget er flyttet fra tråden Upgrade and Upgrade Notebook. Flyttet: jernbane

Kommentar: Dette innlegget er flyttet fra tråden Upgrade and Upgrade Notebook. Flyttet: jernbane

Kommentar: Dette innlegget er flyttet fra tråden Upgrade and Upgrade Notebook. Flyttet: jernbane

I tillegg kan jeg foreslå følgende. Se nøye under BIOS-klistremerket (U3) for hvilken brikke det er. Hvis selskapet er ATMEL, og antallet skjermkort (klistremerke over brikken) starter med 7A. 7B, så blinker ikke disse mikrokretsene. Bare erstatte dem med andre selskaper. Personlig sydde jeg med en programmerer.Programmer

Kommentar: Dette innlegget er flyttet fra tråden Upgrade and Upgrade Notebook. Flyttet: jernbane

Sommeren 2008 kunngjorde Nvidia sin neste kreasjon for spillere, og ga ut GeForce niende serie skjermkort, samtidig som det posisjonerte det som en løsning for rimelige hjemme- eller kontordatamaskiner. Skjermkortet fikk navnet Nvidia GeForce 9500 GT. Teknisk sett finnes grafikkortet i flere versjoner: med 256, 512 og 1024 MB videominne.

Den arkitektoniske likheten til adapteren med den forrige Nvidia GeForce 8500 GT-modellen forklares av den samme GPU-modellen, men med noen forbedrede parametere, for eksempel en økt klokkefrekvens på opptil 550 MHz og en 55 nm prosessteknologi.

Tilkoblingsgrensesnittet til hovedkortet, som i forrige modell, er laget via PCI-E 16x versjon 2.0. Maksimal oppløsning på skjermkortet er 2560x1600 piksler, mens fysisk tilkobling av to skjermer samtidig støttes. RAMDAC-frekvensen er innenfor 400 MHz.

Klokkefrekvensen til grafikkbehandlingsenheten (GPU) er på nivået 550 MHz, og frekvensen til shader-enhetene er 1400 MHz. Typen og mengden videominne for hver enkelt produsent varierer i alternativer:

- 256 og 512 MB med GDDR3-minnetype med en minnebussbredde på 128 biter;

- 1024 MB (av GIGABYTE-utvikler) med GDDR2-minnetype og samme minnebussbredde på 128 biter.

Videominnefrekvensen i versjonen med GDDR2 er estimert til 1000 MHz (som er nøyaktig 200 MHz høyere enn forrige 8500 GT), og i GDDR3-versjonen - 1400 MHz.

Spesifikasjonene til Nvidia GeForce 9500 GT er som følger:

- antall universelle skjermkortprosessorer: 32;

- antall TMUer (teksturenheter): 16 med støtte for shaders versjon 4.0, som gir enda mer realisme til spillingen;

- antall ROP-er er 8;

- maksimal FSA-grad: 16x;

- DirectX 0 versjonsstandarder (en utdatert standard), Open GL 3.2 støttes, selv om moderne skjermkort bruker versjon 4 og høyere;

- NVIDIA PhysX, CUDA, Direct Compute0-teknologier støttes.

En annen åpenbar fordel i forhold til andre skjermkortmodeller er støtten for SLI / CrossFire-tilkoblingsmodus - den såkalte Multi GPU. Dette betyr at brukeren vil kunne kombinere kraften til to identiske skjermkort ved å koble dem gjennom en spesiell MIO-kontakt for å oppnå den høyeste ytelsen flere ganger på alle måter.

Samtidig bemerker produsenten behovet for en datamaskinstrømforsyning på minst 550 W for å opprettholde nødvendig strømforsyning.

Det trykte kretskortet med originale inskripsjoner og uten ekstra strømkontakt er laget i en kompakt stil som ligner på 8500-skjermkortet. Under kjøleren er en monolitisk kjøleradiator som gir høy varmeledningsevne.

Den normale temperaturen på GeForce 9500 GT-skjermkortet, observert under lett grafikk og multimediebelastning, er 45-60 grader. Kan stige til 70 eller mer ved høy GPU-belastning.

Overklokking betyr å øke noe av grafikkortets ytelse til det maksimale for å gi den høyeste ytelsen, om enn tatt i betraktning det økte strømforbruket og høye GPU-oppvarmingen.

For å gjøre dette, anbefales det å bruke gratisprogramvaren Nvidia Inspector eller dens analoge MSI AfterBurner, der prosessorfrekvensen (GPU Clock-verdi), minnefrekvens (Memory Clock) og shader-enhetsfrekvens (Shader Clock) økes trinnvis.

Det ble funnet at overklokking av Nvidia GeForce 9500 GT med DDR2-minnetype og 512 MB RAM kan gjøres opp til følgende verdier:

- GPU-klokke: 620 MHz;

- Minneklokke: 600 MHz;

- Shader-klokke: 1500 MHz

Hovedregelen når du overklokker et hvilket som helst skjermkort er gradvishet. Hver individuelle verdi må økes med noen få MHz og resultatene testes i spillet. Hvis de tillatte verdiene overskrides, vil adapteren tilbakestille verdiene til standardverdiene, og datamaskinen kan fryse, krever omstart av systemet, eller artefakter vil vises på skjermen.

Hvis noen spill i henhold til standardparametrene ikke kan produsere de ønskede grafikkinnstillingene, vil overklokking av Nvidia GeForce 9500 GT-skjermkortet bidra til å øke potensialet til kortet med flere prosent, men ikke mer enn 40%. Du må også sørge for at kjølekjøleren og tilstedeværelsen av termisk pasta fungerer som den skal for ikke å skade skjermkortet.

La oss vurdere prosessen med å overklokke GeForce 9500 GT ved å bruke Nvidia Inspector-programmet (versjon 1.9) som et eksempel:

- Vi starter programmet.

- Klikk på "Vis overklokking"-knappen nederst i vinduet. Programmet vil vise en bekreftelsesforespørsel, vi godtar - klikk "Ja".

- Nvidia Inspector-vinduet vil bli utvidet med ytterligere innstillinger og oppdatert informasjon om prosessorfrekvens, minnefrekvens og shader-frekvens.

- Ved å flytte glidebryteren eller bruke knappene (+1, +10, +20) øker vi GPU-klokkeverdien fra 550 MHz med flere punkter, for eksempel opp til 580 MHz.

- Vi utfører den samme handlingen med verdiene til Memory Clock (maksimum kan økes med 50 %, men ikke mer) og Shader Clock.

- Klikk på "Apply Clocks & Voltage"-knappen for å bruke endringene. Etter at vi har sjekket ytelsesresultatene i spillet.

Vær oppmerksom på at når du slår av eller starter datamaskinen på nytt, tilbakestilles verdiene satt gjennom overklokkingsprogrammet til standardverdiene satt av utvikleren. For å unngå dette, klikk på "Create Clocks Dhortcut" i Nvidia Inspector-programvinduet. Etter det vil programmet lage en snarvei på skrivebordet, ved å klikke på den vil det automatisk sette de lagrede overklokkingsverdiene.

Noen brukere bruker et skjermkort for å tjene kryptografisk valuta på Internett, selv om det anbefales å bruke mer moderne versjoner av grafikkort som støtter høy båndbredde for dette.

Relativt eldgammel etter dagens standarder, kan 9500 GT brukes til gruvedrift gjennom NiceHash-tjenesten, som er mindre krevende for skjermkortets kraft. Hvis vi sammenligner kostnadene for elektrisitet og mottatte inntekter, som i det minste gjør det mulig å betale for bruken av tjenestene til en Internett-leverandør, er gruvedrift på 9500 GT ikke tilrådelig. For å gjøre dette er det bedre å bruke en ny type skjermkort.

Relativt lite krevende spill utgitt før 2008-2010 kjører med middels og til og med høye hastigheter og opprettholder gode FPS-verdier (FPS - antall bilder på skjermen per sekund).

Utgitt senere og mer krevende leker, selv om de vil bli lansert, vil det ikke lenger være mulig å spille dem rolig. I tillegg støtter ikke skjermkortet DirectX 12-versjonen og Open GL 4.

Test i spill GeForce 9500 GT viste gode resultater, som er angitt i tabellen nedenfor. Den første kolonnen inneholder navnene på spillene, den andre og påfølgende - antall bilder per sekund (FPS) i skjermoppløsningen spesifisert i kolonnen. Jo høyere FPS, jo mer stabil er spillingen.

gjør-det-selv modding - modding alexgo

I dette innlegget vil jeg snakke om min erfaring steking (oppvarming) av skjermkort, samt om mislykkede eksempler på steking av skjermkort av andre. Igjen, alt dette er basert på personlig erfaring. Derfor kan mine antakelser og konklusjoner være feil. Likevel fungerer nesten alle skjermkort som er varmet opp av meg den dag i dag.

Denne oppføringen er ikke en veiledning til handling. Jeg, som forfatter, bærer ikke noe ansvar for skade på maskinvaren din på grunn av din egen dumhet eller som følge av skjeve hender.

Så hvorfor varmes skjermkort opp? Videokort varmes opp når videobrikken eller minnebrikkene har "falt av". Det falt ikke av i den forstand at det falt av brettet (fra tekstolitten), men i det faktum at kontakten ble tapt på noen punkter mellom brikken og brettet.

Hvorfor skjer dette? Her kan jeg ikke gi et eksakt svar, men jeg kan bare anta at brikker eller minne (mye sjeldnere) faller av brettet som følge av langvarig eksponering for høye temperaturer. Og kanskje også på grunn av de relativt skarpe temperaturendringene "varm-kald-varm". På en eller annen måte blir forbindelsen mellom kontakten på brikken og kontakten på brettet tapt. Loddekulene forblir enten på brikken eller på brettet. Noen få ikke-fungerende pinner og forårsake feil i driften av skjermkort.

Som regel skjer dette med "varme" (dvs. med stor varmespredning) skjermkort og manifesterer seg vanligvis etter et år eller to med bruk av skjermkortet. For eksempel en kjent serie med GeForce 8800GTSGTX skjermkort (både på den første "varme" G80-brikken og på etterfølgende "kalde"). Men i min praksis var det også kaldere skjermkort, for eksempel nVidia GeForce 6600GT, GeForce 8600GT, Radeon x1600Pro.

Hva er symptomene på "dump" av brikken (forsvinning av kontakt)? Symptomer manifesteres i følgende: artefakter - vertikale fargede striper på skjermen, farget grøt (en hodgepodge, som noen kaller det). Følgende skjedde også flere ganger: uten de installerte driverne ble bildet vist normalt, med installasjonen av driverne var det enten artefakter, eller systemet gikk inn i en BSOD ("blue screen of death").

(Bilder ble for eksempel tatt inn denne oppføringen .)

Hvordan behandle en slik sykdom? Her kommer vi faktisk til det viktigste - stekingen av skjermkortet.

Først vil jeg snakke om dårlige eksempler på andre steking av skjermkort. Så den vanligste måten å varme opp skjermkort på er steking i ovnen... Ja, ja, i ovnen på en vanlig gass (eller elektrisk) komfyr. Denne metoden er veldig populær, sannsynligvis på grunn av ressursen med hans personlige sider , hvor du kan finne eksempler på oppvarming av skjermkort. Jeg har bevisst trukket frem denne metoden i mislykkede eksempler. Jeg anser det som en dårlig måte å steke skjermkort i ovnen.

Hvorfor dårlig, spør du. For i dette tilfellet varmes hele skjermkortet opp, dvs. effekten er på alle komponentene på skjermkortet. Noe jeg ikke synes er akseptabelt. Det enkleste som kan skje er at elementer laget av plast vil smelte. For eksempel videokontakter DVI, VGA og andre, samt strømkontakter. Naive brukere tror at hvis de pakker disse elementene inn i folie, vil dette redde dem fra å smelte. Som praksis viser, er det ikke slik. Enten de er pakket inn i folie eller ikke, vil de smelte, siden skjermkortet i ovnen vil varme opp alt jevnt, vil folien bare bremse denne prosessen. Men litt smeltede kontakter er ikke noe problem. Problemer kan oppstå når andre elementer på skjermkortet overopphetes - ulike elektroniske komponenter, der den maksimalt tillatte temperaturen er mye lavere enn temperaturen på brikken. De vil rett og slett mislykkes, og vi vil endelig gjøre ferdig skjermkortet.

Basert på disse fakta, kan vi lage noen konklusjoner... Nemlig:

- Oppvarming av skjermkortet skal være spot-on, dvs. bare brikken og minnebrikkene skal varmes opp, og ikke hele brettet som helhet.

- Temperaturen, etter min erfaring, bør ikke overstige 220 grader Celsius for å varme opp brikken.

- Oppvarming må utføres jevnt, det er svært ønskelig med en gradvis økning i oppvarmingstemperaturen.

- Oppvarmingstiden bør ikke overstige 5 minutter for en relativt rask oppvarming og 10 minutter for en jevnere.

- Skjermkortet skal avkjøles jevnt, det er ikke nødvendig å blåse det i tillegg.

- Under og etter steking er det svært ønskelig å ikke forskyve, flytte eller riste skjermkortet. Ellers, som et resultat av disse handlingene, kan små komponenter plassert i nærheten av brikken bevege seg eller falle av, siden loddetinn smeltes.

Nå om min erfaring med å steke skjermkort. Da jeg først bestemte meg for å "reparere" skjermkort på lignende måte, forlot jeg umiddelbart stekingen i ovnen. Og i mangel av spesialverktøy gjorde det over brenneren (det brukes også keramiske og elektriske fliser), dvs. over åpen ild.

Mitt neste skritt mot å forbedre kvaliteten, påliteligheten og sikkerheten ved skjermkortreparasjon ved steking var ved hjelp av en hårføner... Jeg bruker for eksempel en Bosch byggtørker. Det er praktisk ved at det har digital kontroll, har flere driftsmoduser og lar deg stille inn ønsket temperatur, samt kraften (hastigheten) til luftstrømmen.Arbeider som en bygningshårføner, for reparasjon tar det meg omtrent tre minutter å varme opp og noen minutter for en jevn naturlig (uten ekstra blåsing) avkjøling av skjermkortet.

Å bruke en bygningshårføner er den beste måten å steke skjermkort på.

Du kan arrangere holivarer på om det er verdt å varme opp skjermkort eller ikke. Når du kontakter et servicesenter med lignende symptomer på et skjermkort, vil du sannsynligvis bli anbefalt å kaste det. Jeg vet at herrene i SC er kategorisk mot en slik "reparasjon". De har faktisk rett i at etter å ha reparert et skjermkort på denne måten, vil de ikke kunne gi noen garantier for varigheten av arbeidet.

Forresten, om varigheten av skjermkortet etter steking. Avhengig av hvem ved hvilken temperatur skjermkortet ble varmet opp, hvor lenge det ble varmet opp og tidspunktet for normal drift av skjermkortet vil variere. Det kan variere fra flere dager, uker, måneder, til flere år (i beste fall).

La oss nå se på flere eksempler på steking av skjermkort, både vellykket og ikke vellykket.

Godt eksempel. Skjermkortet mitt er GF 8800GTS 640Mb. Avbildet før steking. Dessverre er det ingen bilder etter steking, eller rettere sagt, det er, men bare sider med chip. Etter steking smeltet ingenting over brenneren, bare klistremerkene som ikke kunne skrelles av ble mørkere. Skjermkortet måtte stekes flere ganger. Sist gang var lenge siden, jeg husker ikke. Nå er skjermkortet avkjølt av CBO, så det er ingen problemer med overoppheting.

På de personlige sidene til Overclockers.ru kan du finne flere eksempler på steking av slike skjermkort. Og nesten alle er laget ved hjelp av ovnen.

Her er et annet eksempel steking av XFX GTX 280-skjermkortet i ovnen ... I prinsippet fungerte skjermkortet, men noen plastelementer smeltet.

Og så helt dårlig eksempel på steking av skjermkort i ovnen. Eksperimentell Palit 8600gt 256mb sonic+.

Som du kan se, overdrev personen «litt». Som et resultat drepte jeg skjermkortet. Ikke bare elektrolytiske kondensatorer, men også solide kondensatorer (som tåler høye temperaturer) svulmet opp fra oppvarming på skjermkortet. Den beskyttende rammen på brikken rundt krystallen, DVI-kontaktene og viftestrømkontakten ble også smeltet.

For ikke lenge siden ødela én person også det utmerkede 9800GTX+ skjermkortet. Men jeg ba ham ikke varme i ovnen. Å, beklager å se. Det er dessverre ikke noe bilde. Kanskje det vil.

Så alle bestemmer selv om de vil varme opp skjermkortet eller ikke. Hvis han mener at det er verdt det, så anbefaler jeg deg å kontakte en person med erfaring som har riktig verktøy tilgjengelig.

I tillegg vil jeg si at for mer effektiv, riktig steking, er det nødvendig å bruke en flytende fluss, som introduseres under brikken.

Alle finesser og nyanser er ikke beskrevet i denne oppføringen, siden dette ikke er en veiledning til handling, men en introduksjonsartikkel.

Jeg anbefaler deg å ta en titt på dette artikkel om steking av skjermkort .

| Video (klikk for å spille av). |

UPD Jeg anbefaler å lese artikkelen Problemer med nVidia-brikker .